Если вы решили обновить свой старый сайт, прочтите эту статью перед началом работ — она сэкономит вам кучу денег, нервов и времени.

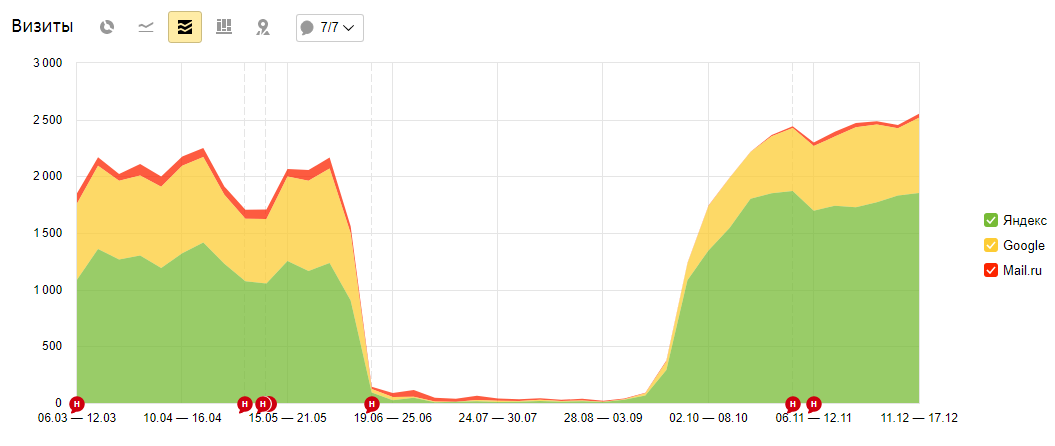

Так повелось что разработчики сайтов средней квалификации часто откровенно недолюбливают seo-специалистов. Они пишут красивый код, иногда даже делают продающий дизайн, но редко разбираются в алгоритмах работы поисковых систем. И свеженький красивый сайт, буквально за несколько дней, теряет 95% посетителей из поиска.

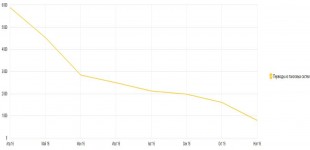

Так было с сайтом одного из наших клиентов. Разработчики выкатили новую версию сайта и за неделю посещаемость из 300 человек в день упала до 15 человек.

Происходит такое падение по разным причинам:

- Удалены страницы с переходами из поиска

- Изменены url страниц без карты редиректов

- Ошибки в robots.txt — сайт закрыт от индексации

- Ошибки верстки — заголовки и мета-теги

Что делать?

Если ваш сайт имеет какую-то посещаемость, с любыми правками нужно быть осторожнее. Узнать точное количество переходов из поиска или социальных сетей на сайт можно в счетчиках веб-аналитики Яндекс Метрика или Google Analytics. У нас есть прекрасный мини-курс «Яндекс Метрика для предпринимателя», который позволит вам научиться самостоятельно оценивать ситуацию по сайту и принимать решения.

Страницы с переходами из поиска

Прежде чем приступить к разработке, определяем самые популярные «Страницы входа» из поисковых систем. К этим страницам особое внимание — они приносят трафик.

По возможности, нужно стараться сохранить контент таких страниц. Процент вхождения ключевых слов, заголовки и мета-теги. Допустимо добавление новых посадочных страниц, тогда старые должны быть доработаны.

Изменение url

Когда нужно менять структуру и адреса страниц, необходимо настроить карту редиректов. Делается это для того чтобы все старые ссылки вели пользователей и поисковых роботов на соответствующие новые страницы. Тогда потери по трафику будут минимальные и новые страницы попадут в поиск в ближайшее время. А большинство пользователей даже не заметят «подмены».

Ошибки robots.txt

Популярными ошибками являются:

- Развертывание сайта на dev-версии сервера (для разработки), без запрета индексации. Это приводит к дублям в поиске.

- Заливка новой версии на основной домен с запретом индексации в robots.txt. Сайт за несколько дней исчезает из выдачи.

Рекомендация здесь простая: перед заливкой сайта куда угодно всегда проверять файл robots.txt.

Ошибки верстки

Не целевое использование заголовков H1-H6, отсутствие мета-данных, битые ссылки, ошибки javascript, нет адаптивной/мобильной версии. И множество других проблем, от которых оградит техническое задание или консультация seo специалиста до начала разработки.

Идеальный сценарий

По хорошему, перед разработкой новой версии сайта собрать семантическое ядро запросов, по которым вы хотите продвигаться. А также провести комплексный аудит старого сайта. То есть начинать работу с seo специалистами а уже потом с разработчиками. Продвинутые маркетинговые агентства решают обе эти задачи.

Совмещение разработки и продвижения удорожает разработку, но снижает затраты и сроки на продвижение. Качественная работа не может стоить дешево.

Если разработчики свои — возьмите seo сопровождение создания сайта. Специалисты помогут обратить внимание на важные детали в нужное время и избежать потерь.

Сроки и условия

Подписаться

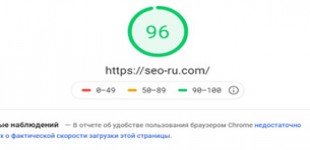

Отчёт